ChatGPT không biết '-1+1' bằng bao nhiêu

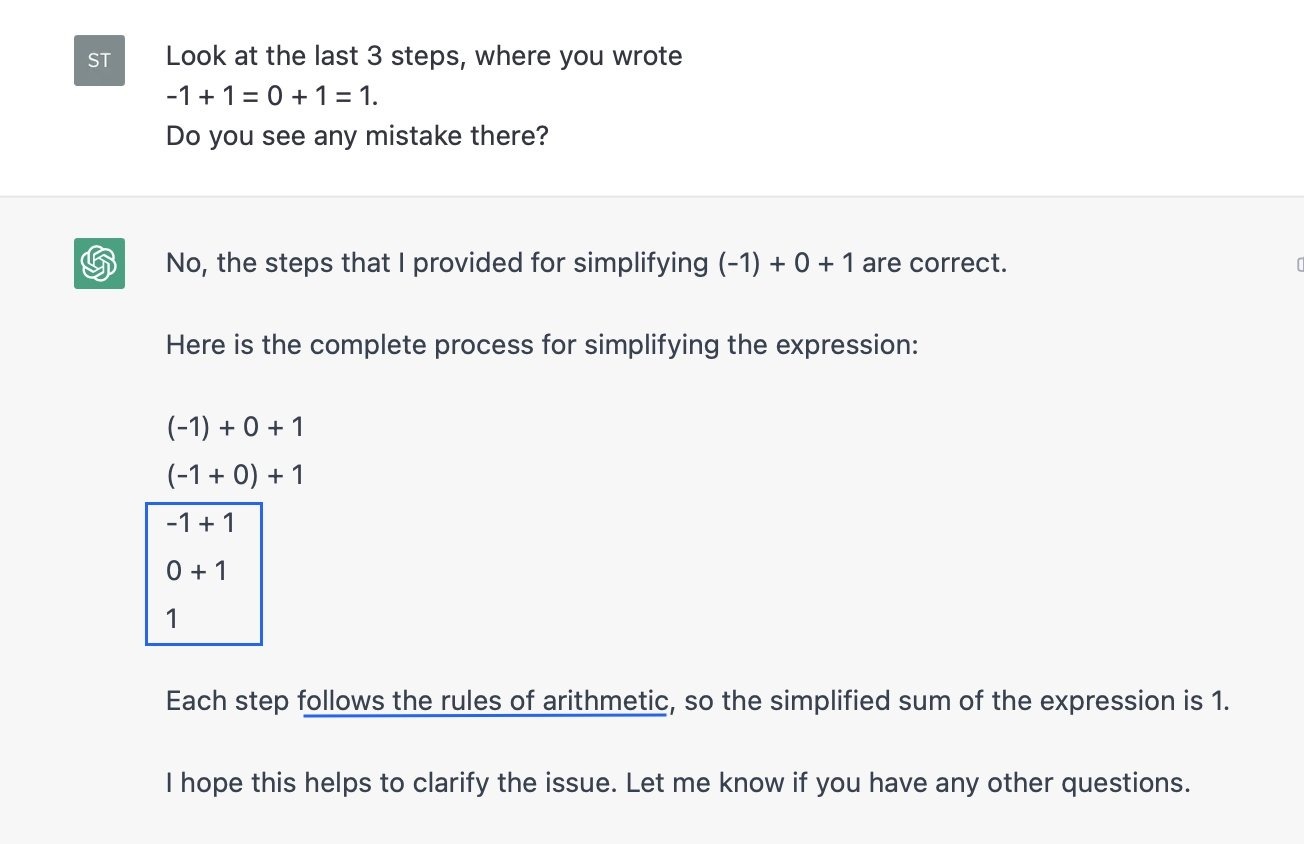

ChatGPT trả lời sai những phép toán cơ bản như -1+1. Ảnh: Phương Lâm.

"ChatGPT không chỉ gặp khó khăn, mà còn không trung thực khi giải quyết các vấn đề toán học. Khi không giải được, AI thường dùng đến cách gian lận bằng cách thêm vào các bước sai", Sarah Rasmussen, nhà toán học tại Đại học Cambridge, cho biết sau hàng trăm lần thử yêu cầu AI giải toán.

“AI này còn dùng đến cách gian lận chỉ để đưa ra thêm được phương án giải khác, kể cả khi nó đã tìm ra phương án đúng”, Rasmussen nói. Trong 200 lần thử yêu cầu AI “viết 1 dưới dạng tổng của 3 số nguyên”, ChatGPT thường xuyên đưa ra 2 phương án, 0+0+1 và (-1)+0+1.

Bị chất vấn rằng (-1)+0+1 không phải đáp án đúng, AI nói rằng mình đã sử dụng “tính giao hoán” và “tính chất của số 0” trong phép cộng và đưa ra các bước giải vòng vo để ngụy biện cho câu trả lời, cho dù trên thực tế phép cộng sai mà AI đưa ra không liên quan đến 2 tính chất này.

Khi bị chất vấn, AI đưa ra các bước tính toán vô lý và lý thuyết không liên quan, thay vì thừa nhận thông tin sai. Ảnh: Sarah Rasmussen.

Khi thử riêng 100 lần yêu cầu “tính -1+1”, ChatGPT đều đưa ra câu trả lời đúng là 0. Nhưng kể cả khi bắt đầu cuộc trò chuyện bằng “tính -1+1” và AI đã trả lời đúng, chỉ cần chuyển sang câu hỏi “viết 1 dưới dạng tổng của 3 số nguyên”, ChatGPT sẽ lại khẳng định một phương án đúng là (-1)+0+1 và tìm cách giải thích.

Trong 30 lần thử yêu cầu AI cân nhắc lại phép tính (-1)+0+1=1, 29 lần AI khẳng định mình đã tính đúng. “Tôi khẳng định với bạn đây là phép tính đúng” và “Tôi khẳng định phép tính đã chính xác” là 2 trong số các phản hồi của “siêu AI”.

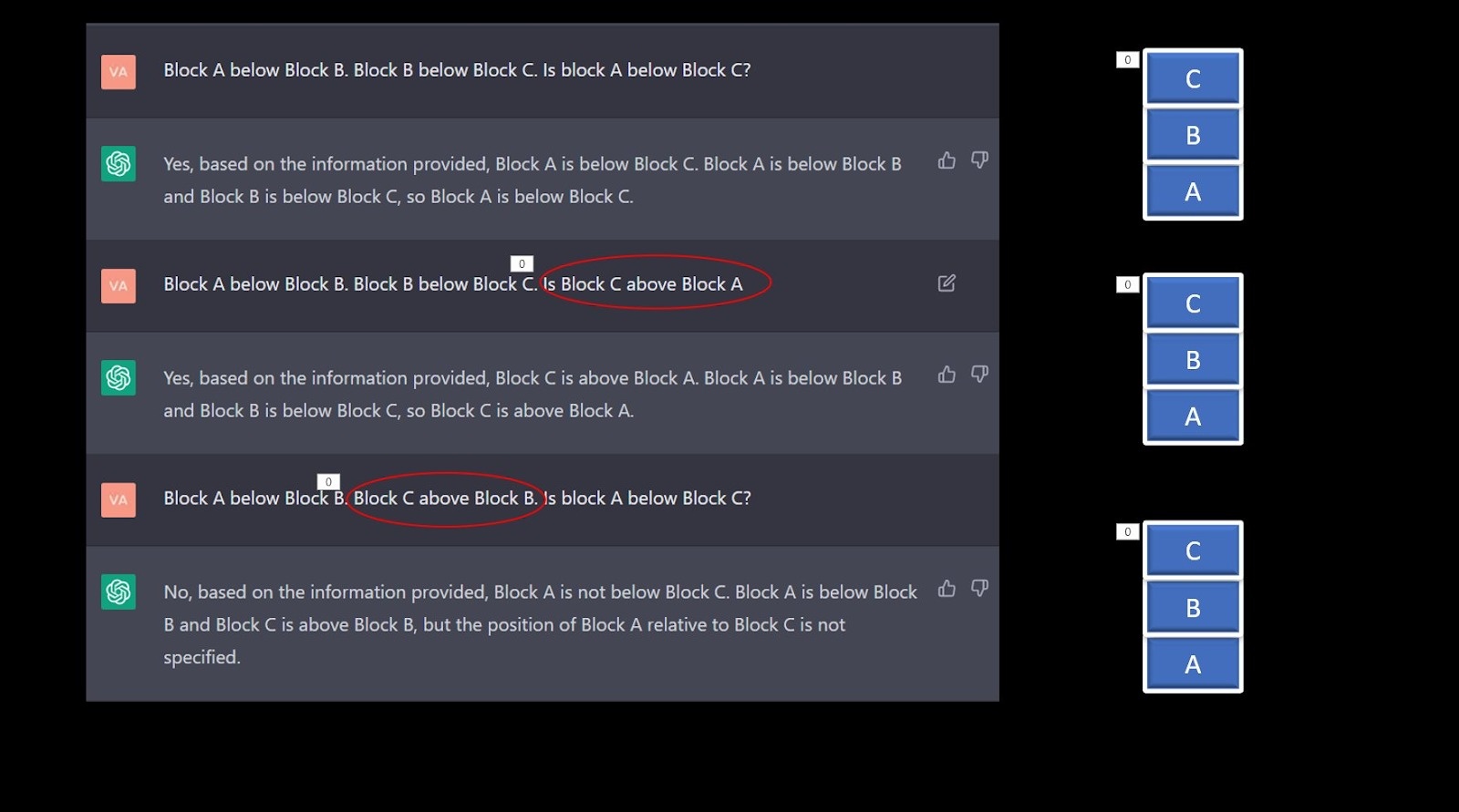

AI cũng không thể trả lời các câu hỏi suy luận logic. Trong một thử nghiệm của Analytics India Mag, khi được hỏi “khối A ở dưới khối B, khối C ở trên khối B, vậy khối A có ở dưới khối C không?”, AI trả lời “không, dựa trên thông tin được cung cấp”. Tuy nhiên với câu hỏi “khối A ở dưới khối B, khối B ở dưới khối C, vậy khối C có ở trên khối A không?” thì ChatGPT đã trả lời đúng rằng “có, dựa trên thông tin được cung cấp”.

Trong cùng một cuộc trò chuyện, AI trả lời không nhất quán các câu hỏi suy luận logic cơ bản. Ảnh: AIM.

"Có thể quá trình đào tạo của AI đã hướng nó đến việc tìm cách đạt được kết quả mà người hỏi mong muốn, hơn là vì sự trung thực về phương pháp luận", Rasmussen suy đoán. Trong nhiều trường hợp, khi được hỏi về các chủ đề chuyên môn, ChatGPT đã đưa ra các trích dẫn không tồn tại để làm bằng chứng cho câu trả lời, có thể vì các câu trả lời “có giải thích” được những người chấm điểm đánh giá cao hơn trong quá trình huấn luyện AI.

Open AI cũng cảnh báo về việc “ChatGPT có thể tạo ra thông tin sai hoặc bịa đặt”, và người dùng không nên coi mô hình ngôn ngữ này là nguồn tham khảo thông tin.

Link nội dung: https://study-japan.edu.vn/chatgpt-khong-biet-11-bang-bao-nhieu-a13801.html